已經進行了四天,還蠻有毅力~~(為了包包)

現在來講講機器的'偏見"吧

甚麼?機器也有偏見,我以為機器是最公正的!!!

但是事實就是這樣,

其實之前TIMES就有報導這樣的新聞3

https://time.com/5520558/artificial-intelligence-racial-gender-bias/

把蜜雪兒歐巴馬判斷成男性,一位女性還被判斷成男生的機率高達75%!!!(我的天呀)

所以說機器是存在偏見的,那為何呢?

這應該是因為機器學習的來源有關!沒錯就是"歷史資料"

想一下以前大多的科學家或是醫生大多都是男生對吧

當你只有輸入幾乎都是男生的資料當然很容易判斷成男生。

那要怎麼預防?

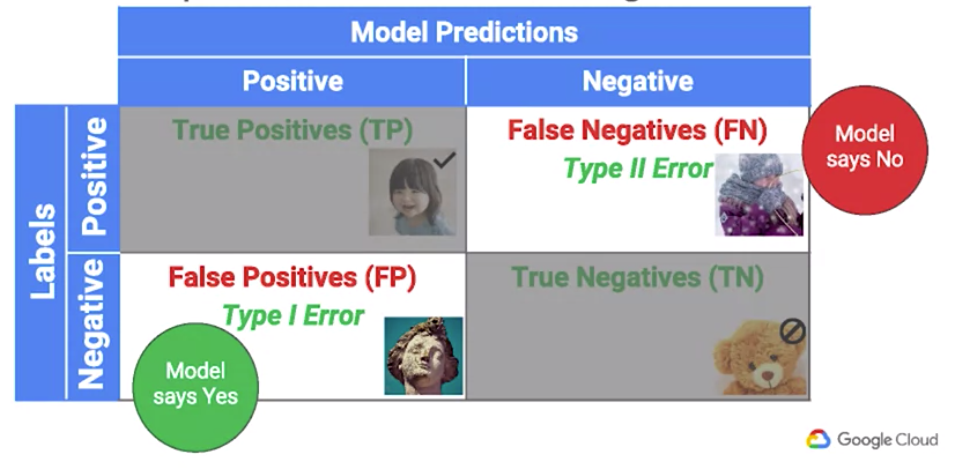

先來講一個混淆矩陣的概念

簡單的來說就是如下

大致上可以歸類成以下二分法的四種狀況

True Positive (TP):真正答對的意思 是圈答成圈

True Negative (TN):真正答錯的意思 是叉答成圈

False Positive (FP):答對的意思 是叉答成圈

False Negative (FN):答錯的意思 是圈答成叉

就好像以前皇帝要殺人的時候,寧可錯殺一個也不可以少殺一個的意思一樣

那實際是要怎麼做呢???

簡單的來就是要讓你的TP以及TN的準確率提高,FP、FN降低的意思

越需要精密的東西TP以及TN的準確率就要越高,FP、FN越低

當然GOOGLE也講了一個機會均等的的概念

不應該是因為是性別或是膚色等天生因素影響到真正的判讀,應該用例如成績、收入之類的來當作指標

先這樣,明天繼續。